„Studie ukazuje, že vytoužený „kolečko“ LLM tréninku zůstává zatím mimo naše možnosti“

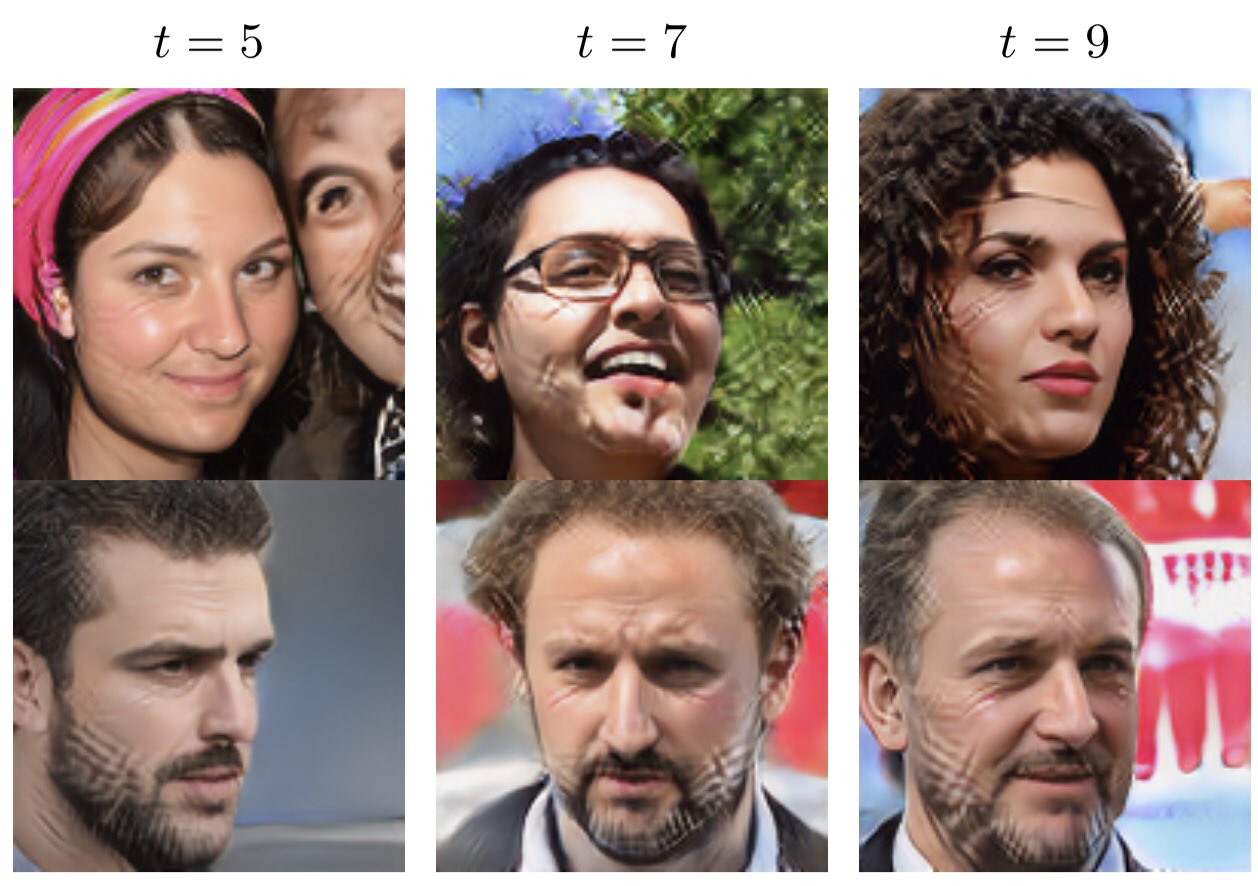

Nový výzkum naznačuje, že dlouho očekávané „kolébka“ tréninku modelu LLM (kdy je model trénován s využitím vlastních výstupů) je momentálně mimo naše možnosti. Autoenkodéry, gaussovské směsi a velké jazykové modely byly všechny prokázány jako ovlivněné.

Autoenkodéry jsou neuronové sítě, které se snaží efektivně reprezentovat vstupní data. Bohužel, při použití v LLM tréninku dochází k ohromnému množství chyb, které se opakují a zhoršují. Tento problém je důsledkem tzv. „kolébky“, kdy se model učí na základě svých vlastních nekvalitních odhadů. Výsledkem je, že se model stále více a více odchyluje od skutečných dat.

Gaussovské směsi, což jsou modely pravděpodobnosti, jsou také postiženy tímto problémem. Při tréninku dochází k „kolébání“, kdy model generuje nesprávné hodnoty pro rozložení pravděpodobnosti. Tento jev výrazně ovlivňuje schopnost modelu generovat správné výstupy.

Velké jazykové modely jsou také náchylné k „kolébání“. Tyto modely jsou trénovány na obrovském množství textových dat a mají za cíl generovat plynulý a gramaticky správný text. Bohužel, při použití „kolébky“ dojde k tomu, že model začne generovat nesmyslné nebo nekonzistentní texty.

Kromě těchto tří příkladů se ukázalo, že i jiné trénovací metody LLM jsou náchylné na tento problém. V současné době neexistuje žádné spolehlivé řešení pro efektivní trénování modelů LLM s využitím jejich vlastních výstupů. Další výzkum je potřebný.

FAQ:

1. Jak se projevuje „kolébka“ v tréninku LLM?

Při použití „kolébky“ dochází k opakování chyb a zhoršování výsledků modelu.

2. Jaké metody trénování jsou ovlivněny „kolébkou“?

Autoenkodéry, gaussovské směsi a velké jazykové modely jsou všechny postiženy tímto problémem.

3. Existuje řešení pro efektivní trénování modelů LLM s využitím jejich vlastních výstupů?

V současné době neexistuje žádné spolehlivé řešení pro tento problém. Další výzkum je potřebný.